【背景】

最近研究域自适应语义分割,看到两篇比较好玩的文章。遂记录下来,供今后找点灵感。

【描述/动机】

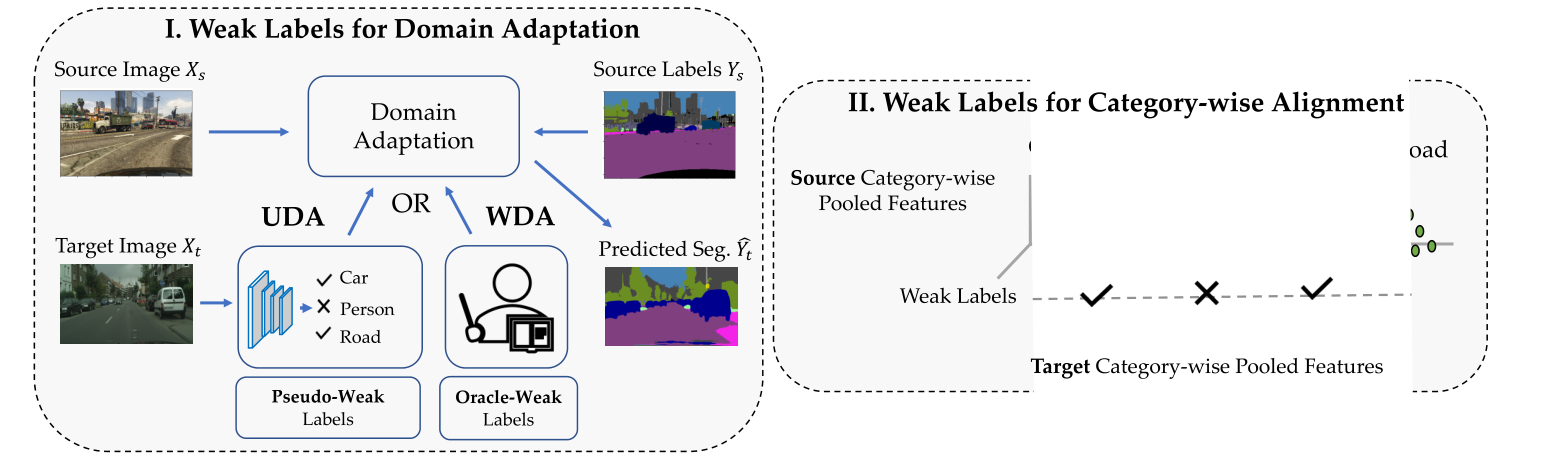

学习语义分割模型需要大量的像素标记。然而,标记数据可能仅在与期望的目标域不同的域中大量可用,该域仅具有最少或没有注释。在这项工作中,我们提出了一个新的框架,用于在目标域中使用图像级弱标签进行语义分割的域自适应。弱标签可以基于无监督域自适应(UDA)的模型预测来获得,或者从用于语义分割的新的弱监督域自适应(WDA)范例中的人类注释器获得。使用弱标签既实用又有用,因为(1)在WDA收集图像级别的目标注释相对便宜,并且在UDA中不产生成本,(2)它为分类领域对齐打开了机会。我们的框架使用弱标记来实现特征对齐和伪标记之间的相互作用,在域自适应过程中改进了这两者。

【核心思想】

我们的工作引入了两个关键思想来适应跨领域的语义分割模型。一:使用图像级弱标注进行领域自适应,要么是估计的,即伪弱标签(无监督领域自适应),要么是从human-oracle中获得的(弱监督领域自适应(WDA)。我们利用弱标签来改善源域和目标域之间的分类特征对齐。X/表示弱标签,即图像中存在/不存在的类别.

【网络架构】

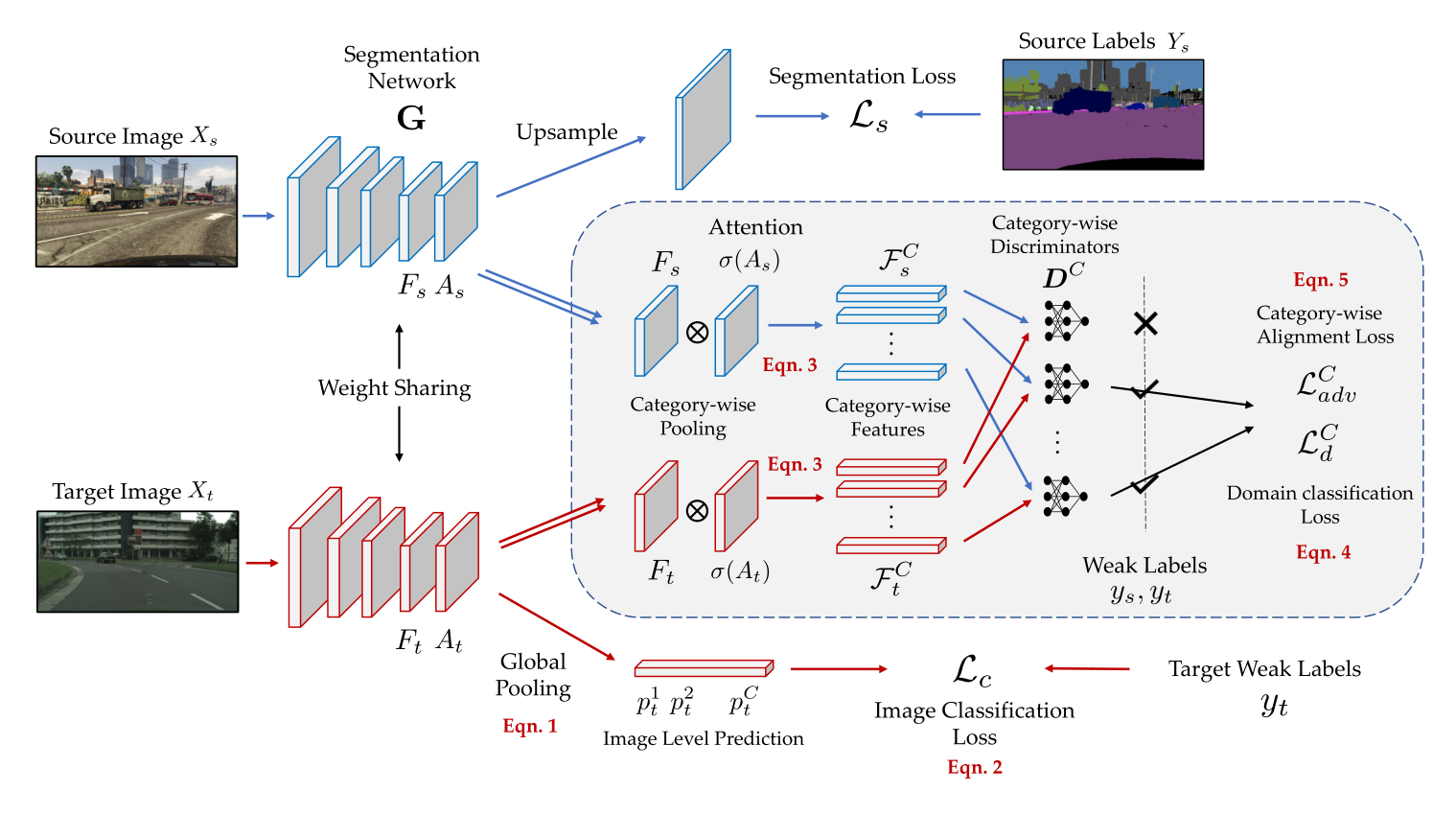

上图是整个网络的构架。首先将源图像和目标图像通过分割网络G,并获得它们的特征

除了在源数据上有像素级的标签,我们还在目标数据上有图像级的弱标签。如前所述,这样的弱标签可以是估计的(UDA),也可以是从human-oracle(WDA)获得的。然后,我们利用这些弱标签以两种不同的方式更新分割网络

【弱标签】

为了预测特定图像中是否存在类别,我们使用弱标签定义了图像分类任务,使得分割网络

其中σ是sigmoid函数,因此

1,因为我们不希望网络只关注预测的最大值(可能有噪声),还关注其他可能具有高值的预测。使用

这体现于框架图的底部,这个损失用于识别特定图像中缺失或存在的类别,并强制分割网络

【标签对齐】

在中引入的使用弱标签的分类损失规范了集中于某些类别的网络。然而,还没有考虑跨源域和目标域的分布对齐。如前一节所讨论的,一些方法跨域对齐特征空间或者输出空间。然而,这种对齐与类别无关,因此它可以对齐某些图像中不存在的类别的特征。此外,属于不同类别的特征可能具有不同的领域差距。因此,执行类别对齐可能是有益的,但在语义分割领域尚未得到广泛研究。虽然有工作试图对齐分类特征,但它使用像素伪标签,这可能有噪声,并在高维特征空间中执行对齐,这不仅难以优化,而且需要更多的计算量。

为了缓解上述问题,我们使用图像级弱标签在特征空间中执行分类对齐。具体来说,我们通过注意力图(即分割预测)获得每幅图像的分类特征,在分类模块的指导下使用弱标签,然后在源域和目标域之间对齐这些特征。

分类级特征池化

给定最后一层特征

其中

分类特征对齐

为了学习分割网络

值得注意的是,在训练鉴别器时,我们仅通过弱标签

类似地,我们使用目标弱标签

【网络优化/训练】

训练鉴别器

我们为每个类别学习一组不同的判别器。我们使用源图像和目标图像来训练判别器,这些判别器学习区分从源域或目标域提取的类别特征。训练鉴别器的优化问题可以表示为:

训练分割器

利用源图像的像素交叉熵

我们用标准的GAN训练程序,交替更新

【获取伪标签】

Pseudo-Weak Labels (UDA).

获得弱标签的一种方法是使用我们拥有的数据直接估计它们,即源图像/标签和目标图像,这是无监督域自适应(UDA)用过的方法。在这项工作中,我们利用基线模型将从源域学习的模型调整到目标域,然后获得目标图像的弱标签,如下所示:

其中,

Oracle-Weak Labels (WDA)

在这种弱标签获取方法中,我们通过查询一个human-oracle来获得弱标签,以提供目标图像中出现的类别列表。当我们在目标映像上使用oracle的监督时,我们称之为弱监督域适应(WDA)。值得一提的是,WDA设置实际上可能很有用,因为收集这种人为标注的弱标签比像素标注容易得多。此外,还没有任何先前的研究涉及这种领域适应设置。

为了证明我们的方法可以使用不同形式的弱标记,我们进一步引入了如[2]中的点监督,与图像级监督相比,它只增加了少量的工作。在这种情况下,我们随机获得属于图像的每个类别的一个像素坐标,即元组集

【总结】

山穷水尽时多思考从数据本身做增强的方法,循环利用弱标签说不定会有奇效。具体得看看怎么用吧(视情况而定)。

【参考文献】

Sujoy Paul, Yi-Hsuan Tsai, Samuel Schulter, Amit K. Roy-Chowdhury, Manmohan Chandraker. Domain Adaptive Semantic Segmentation Using Weak Labels. in ECCV 2020